Chałkoń z farmy lajków. Humor w social mediach i jego ciemne oblicze

Internet żyje trendami, a jednym z największych w ostatnim czasie jest tzw. Chałkoń. Wygenerowany przez sztuczną inteligencję żart, wskazuje na skuteczność virali w kształtowaniu opinii publicznej i skłania do pytań o zagrożenie rozprzestrzeniania się dezinformacji.

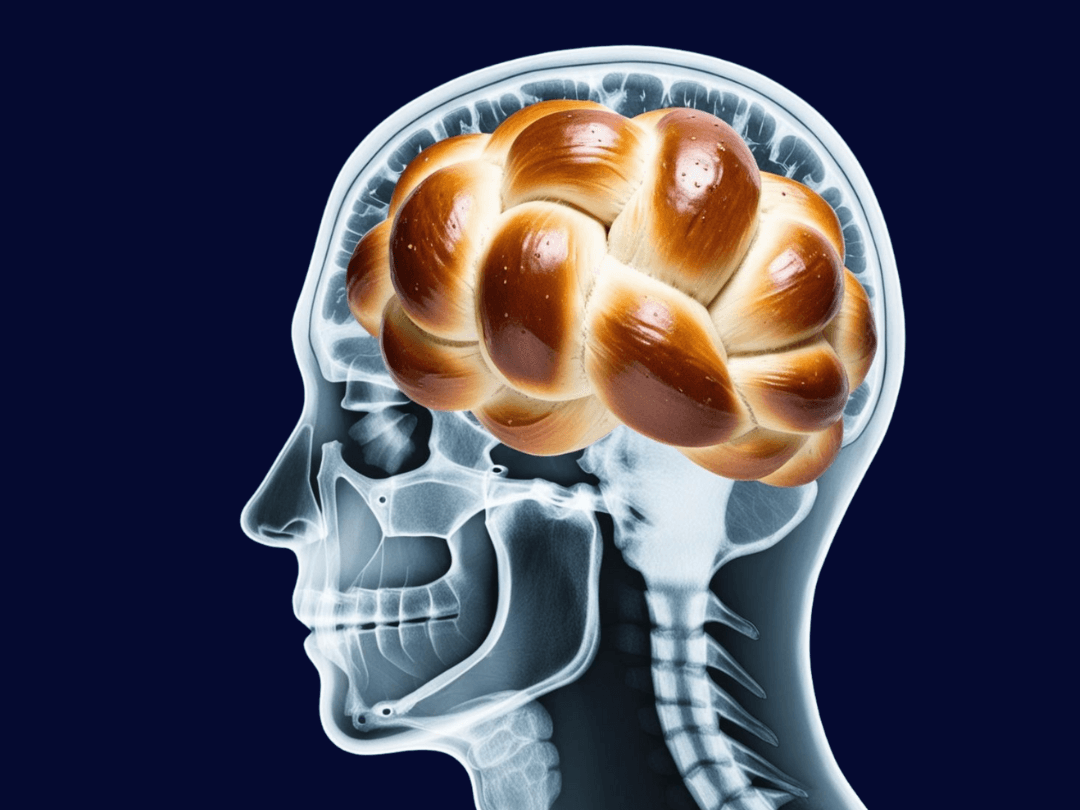

Żywot Chałkonia rozpoczął się jako satyryczny post na Facebooku na fanpage’u „Polska w dużych dawkach”. Twórcy profilu dostrzegając, że portal jest zalewany generycznymi postami tworzonymi pod starszych użytkowników portalu o treści „ktoś zrobił X, ale nikt mu nie pogratulował” postanowili dla żartu przygotować własną wersję takiego posta. Opublikowali grafikę przedstawiające nietypowy wypiek – ogromną chałkę w kształcie przypominającym konia z dopiskiem „Ta kobieta upiekła Chałkonia, ale nikt jej nie pogratulował”. Dla tysięcy internautów wygenerowana przez sztuczną inteligencję grafika okazała się na tyle przekonująca, że uznali oni historię za prawdziwą.

„Chałkoń okazał się bestią, której potęgi nie doceniliśmy” – napisali po kilku dniach autorzy fanpage’u „Polska w dużych dawkach”.

źródło: facebook @Polska w dużych dawkach

Trend szybko rozprzestrzenił się w sieci i zyskał ogromną liczbę komentarzy, memów i przeróbek graficznych. Popularność Chałkonia doprowadziła do tego, że wiele firm i marek zaczęło wykorzystywać go w swoich kampaniach reklamowych. Internetowe żarty o Chałkoniu stały się niemal kultowe. Za całą akcją kryją się jednak ważniejsze kwestie: podatność ludzi na dezinformację i siła viralowych treści.

„Tym przerysowanym, karykaturalnym postem zebraliśmy ogromne zasięgi, post zobaczyło ponad milion osób. W komentarzach pojawiły się nieironiczne gratulacje dla twórczyni Chałkonia, głównie od starszych osób, przeplatane oczywiście ze śmieszkami czy (na szczęście) ostrzeżeniami, że to jest grafika AI” – zauważają autorzy fanpage’u „Polska w dużych dawkach”.

Jak zwracają uwagę twórcy fanpage’u, historia Chałkonia to dowód na to, że takich sytuacji będzie coraz więcej, ten niewinny żart pokazuje dużo szerszy i niebezpieczny problem.

„Najwięcej materiałów wygenerowanych przy użyciu sztucznej inteligencji, na które możemy natrafić, pojawia się na platformach społecznościowych. Często są to materiały tworzone masowo, różniące się jedynie drobnymi szczegółami, takimi jak odgłosy w tle czy inne niewielkie zmiany. Analizując metadane takich treści – publikowanych najczęściej w formie reklam – można zauważyć, że najbardziej popularną grupą odbiorców są osoby w wieku 45–60 lat. Oszuści mają możliwość samodzielnego wyboru grupy docelowej, co sugeruje, że populacja w tym przedziale wiekowym może być uznawana za „najłatwiejszy” cel cyberprzestępców. Warto zwrócić na to uwagę, przyglądając się temu trendowi – podkreśla Adrian Kordas, ekspert z Ośrodka Badań nad Bezpieczeństwem Sztucznej Inteligencji w NASK

Humor kontra dezinformacja

Fenomen Chałkonia pokazuje, że internauci uwielbiają humorystyczne, absurdalne treści, które pozwalają na chwilowe oderwanie się od codziennych problemów. Ten rodzaj rozrywki łączy ludzi i pobudza twórczość. Jednak, mimo że Chałkoń był żartem, jego dynamiczne rozprzestrzenianie się pokazało, jak łatwo można zmanipulować ludzi, nawet za pomocą oczywistej fikcji. Wiele osób uwierzyło w autentyczność tej historii, dowodzi to, jak podatni jesteśmy na niezweryfikowane informacje w mediach społecznościowych.

“Ludzie w pierwszym kontakcie z nową informacją mają tendencję do automatycznego uznawania jej za prawdziwą. Dopiero gdy dostrzeżemy szczegóły, które wskazują na potencjalne oszustwo, zaczynamy ją kwestionować. Wraz z rosnącą skutecznością sztucznej inteligencji w generowaniu wysokiej jakości obrazów i tekstów, rozpoznanie takich szczegółów staje się coraz trudniejsze. Dodatkowo mała wiedza o metodach tworzenia tych treści, domyślne zaufanie do treści w Internecie oraz socjotechniki wzmacniające zaangażowanie odbiorców sprawiają, że tego typu publikacje zyskują na popularności, a ich fałszywy charakter umyka uwadze wielu internautów” – zwraca uwagę Michał Ołowski z Ośrodka Badań nad Bezpieczeństwem Sztucznej Inteligencji w NASK.

Im bardziej absurdalna lub emocjonalna treść, tym większe prawdopodobieństwo, że zostanie masowo udostępniona i przetworzona, a nie wszyscy potrafią oddzielić żart od rzeczywistości. W przypadku Chałkonia sytuacja wydaje się nieszkodliwa, ale mechanizm, na którym się opiera, może być wykorzystywany do mniej żartobliwych celów.

Chałkoń jako ostrzeżenie

W historii Chałkonia trudno doszukiwać się elementów dezinformacji jednak nie można pominąć, że wpisuje się on w zjawisko AI slop (ang. artifficial intelligence – sztuczna inteligencja i slop – pomyje), czyli generowanie grafik, które są tandetne i dość łatwo rozpoznać, że nie przedstawiają rzeczywistości. A to z kolei może (choć nie zawsze musi) łączyć się z AI slop boomertrap, czyli „pułapki na boomera”, na którą “złapać” mogą się osoby urodzone w latach 1940-1970.

„Choć przypadek Chałkonia miał na celu czysto humorystyczny aspekt, to samo zjawisko AI slop boomertrapów jest niezwykle szkodliwe. Materiały tego rodzaju są publikowane najczęściej po to, aby badać reakcje odbiorców. Pojedyncze publikacje w mediach społecznościowych lub całe wygenerowane strony mogą być źródłem oszustw finansowych oraz aktywizacji użytkowników wokół określonego tematu. Aktorom dezinformacji pozwala to na gromadzenie danych o profilach wybranej, podatnej grupy w celu późniejszego prowadzenia fałszywych kampanii” – mówi Izabela Jarka, kierownik Zespołu Szybkiego Reagowania i Wykrywania Dezinformacji.

Żeby mówić o AI slop boomertrap, publikacja treści musi mieć na celu budowanie zasięgu i zaangażowania użytkowników w mediach społecznościowych.

„Od pewnego czasu obserwujemy ten trend w kampaniach dezinformacyjnych. Jest on niezwykle niebezpieczny szczególnie dla starszych odbiorców, którzy chętnie wchodzą w interakcje z podobnymi materiałami, np. na profilach dotyczących aspektów religijnych. Następstwem komentarza bądź polubienia jest kontakt z taką osobą poprzez wiadomość prywatną i próba wyłudzenia danych, środków lub przekierowania do innego komunikatora, aby podtrzymać kontakt z potencjalną ofiarą. Budowanie zaangażowania i odwoływanie się do emocji mogą osłabiać czujność niektórych użytkowników, dlatego tak ważne jest budowanie świadomości społecznej w tym zakresie” – dodaje Izabela Jarka.

Generatywny spam

Chałkoń to idealny przykład na to, jak viralowe treści mogą wpływać na masową wyobraźnię. Z jednej strony to zabawny fenomen, który zjednoczył internautów wokół humorystycznego żartu, z drugiej – ostrzeżenie przed siłą dezinformacji i potrzebą krytycznego podejścia do treści w sieci.

„Internet daje ogromne możliwości twórcze, ale wymaga też odpowiedzialności – bo nawet chałka w kształcie konia może pokazać, jak łatwo dać się wprowadzić w błąd. To szczególnie ważne w momencie, gdy Social Media, a w szczególności Facebook są zalewane treściami niskiej jakości, które generują algorytmy AI” – podsumowuje Michał Ołowski z Ośrodka Badań nad Bezpieczeństwem Sztucznej Inteligencji w NASK.

Generowane przez AI grafiki mogą być wykorzystywane przez spamerów i do szerzenia fałszywych informacji, manipulując faktami i przyciągając uwagę użytkowników. W przypadku szkodliwych treści zawsze warto przeciwdziałać, zgłaszając materiał jako spam bezpośrednio na platformie społecznościowej. Trzeba jednak mieć na uwadze, że przez brak odpowiednich regulacji na platformach takich jak Facebook, skuteczna moderacja treści jest trudna. W tym momencie najlepszą ochroną jest edukacja i ostrożność samych użytkowników w konfrontacji z postami, które pojawiają się w mediach społecznościowych.

Projekt dofinansowany przez UE.

Wyróżnione aktualności

Fakty, nie mity. NASK i UMB wspólnie przeciw dezinformacji medycznej

NASK podpisuje kolejne porozumienie przeciwko dezinformacji medycznej i mówi stanowcze „nie” fake-newsom na temat zdrowia. Po Warszawskim Uniwersytecie Medycznym, czas na Uniwersytet Medyczny w Białymstoku.

Szkoły coraz bliżej technologicznej rewolucji. Znamy oferty na szkolne laboratoria przyszłości!

Edukacyjna rewolucja nabiera tempa. Tysiące szkół w całej Polsce już wkrótce zyskają nowoczesne pracownie, w których uczniowie będą mogli rozwijać cyfrowe umiejętności i poznawać technologie przyszłości. 30 października w NASK otwarto oferty firm, które chcą wyposażyć szkoły w laboratoria sztucznej inteligencji i STEM – miejsca, gdzie nauka spotka się z technologią.

Zostań internetowym detektywem i sprawdź się w zawodach OSINT CTF

Internetowe śledztwa, szukanie tropów i łączenie kropek – brzmi znajomo? Jeśli lubisz rozwiązywać zagadki ukryte w labiryncie danych, zawody OSINT CTF NASK 2025 to miejsce, w którym poczujesz się jak w domu. Właśnie rusza rejestracja uczestników.

Kongres OSE 2025 – zarejestruj się!

Jak promować język szacunku w cyfrowym świecie? W jaki sposób budować w szkole przestrzeń dla dialogu i różnicy zdań? Na te i inne pytania odpowiedzą eksperci podczas Kongresu OSE, który jest organizowany przez NASK. Wydarzenie odbędzie się 2 grudnia. Właśnie ruszyła rejestracja uczestników. Na zgłoszenia czekamy do 24 listopada.

Najnowsze aktualności

Od lajków do lęków – zaburzenia odżywiania w erze scrollowania

Zaburzenia psychiczne związane z jedzeniem i zniekształcony obraz ciała coraz częściej zaczynają się od ekranu telefonu. Problem ten wpisuje się szerzej w kryzys zdrowia psychicznego zanurzonych w środowisku cyfrowym młodych ludzi. Nastolatki patrzą na idealny świat w mediach społecznościowych, a siebie widzą w krzywym zwierciadle.

Port Polska z NASK

Rozwój nowoczesnej infrastruktury transportowej to dziś nie tylko wyzwanie inżynieryjne, ale również cyfrowe. W erze, gdy każdy element systemu jest połączony i zdigitalizowany, odporność na zagrożenia cybernetyczne staje się równie istotna jak beton czy stal.

Jak nie utonąć w oceanie internetu? NASK podpowiada

Cyberprzestępcy nie śpią, a ich metody zmieniają się tak szybko, jak szybko rozwija się technologia. Jak nie dać się złapać w sieciowe pułapki? Z pomocą przychodzi nowa publikacja NASK – „ABC cyberbezpieczeństwa 2.0”, poradnik przygotowany w ramach OSE.